冠军方案 | 深兰科技包揽 ICCV2021 无人机挑战赛双冠军

2021-10-1410月11日至10月17日,2021国际计算机视觉大会International Conference on Computer Vision (ICCV)于线上拉开序幕。此次会议,深兰科技DeepBlueAI团队共参加2项比赛4个赛道,分别在VisDrone Object Detection,VisDroneMot,Large-AI-Food三个赛道获得冠军。VisDrone 已成为无人机领域标杆数据集,且业界多篇论文在此数据集基础上研究发表。

本次无人机挑战赛吸引来自全球多家知名团队参与角逐,其中不乏多所高校与顶级技术团队,包括清华大学、中科院计算所、北京邮电大学、腾讯、谷歌等上百支知名团队参赛。以下主要分享在无人机挑战赛中两个赛道的方案解读。

冠军方案解读

本次挑战赛深兰团队包揽两个赛道的冠军:

●任务1:图像中的目标检测。任务旨在从无人机拍摄的单个图像中检测预定义类别的对象(例如,汽车和行人);

●任务 2:多目标跟踪挑战。该任务旨在恢复每个视频帧中对象的轨迹。

VisDrone Object Detection 方案解读

挑战赛官网地址:http://aiskyeye.com/

VisDrone数据集由天津大学机器学习与数据挖掘实验室 AISKYEYE 队伍负责收集,全部基准数据集由无人机捕获,包括 288 个视频片段,总共包括 261908 帧和 10209 个静态图像。

这些帧由 260 多万个常用目标(如行人、汽车、自行车和三轮车)的手动标注框组成。为了让参赛队伍能够更有效地利用数据,数据集还提供了场景可见性、对象类别和遮挡等重要属性。

VisDrone Object Detection 赛道获奖证书

据DeepBlueAI团队介绍,虽然该比赛已举办多届,仍然存在以下几个难点:

1. 大量的检测物体

2. 部分目标过小

3. 不同的数据分布

4. 目标遮挡严重

数据分布

遮挡数据量统计

针对数据集难点,DeepBlueAI团队设计了一套强有力的数据增强方式和pipeline。

数据处理

1、数据平衡

上图为每一类数据在训练集中的数量(举例:6471张训练集中,有1150张包含awining-tricycle这个类),将每一类图片数量小于4000张的,通过随机加噪声、改变亮度、cutout等方式扩充为4000张,以缓解类别不平衡的问题。

2、中心裁剪

用中心裁剪的方式,随机在原图上裁剪320~960大小的区域,然后把它们resize为相近的尺度,以缓解目标尺度不一致的问题。上面第一行是在原图中切了960×960大小,第二行是切了320×320大小,把它们resize到同一个尺度(如640×640),相当于达到了小目标放大、大目标缩小的目的。并且对于边界目标是全保留的策略。

3、马赛克增强

马赛克数据增强将4张训练图像按一定比例组合成1张,丰富了检测数据集, 增加了很多小目标。Mosaic是YOLOv4中引入的第一个新的数据增强技术。这使得模型能够学习如何识别比正常尺寸小的物体。它还鼓励模型在框架的不同部分定位不同类型的图像。通过缩放,以及一次计算4 张图片,充分利用了 GPU 资源,使得 batch_size 不用很大就能达到很好的效果。

消融实验:数据处理带来了很大的收益

PipeLine

Swin-Transformer+ CBNet + Cascade RCNN + DCN + FPN

Cbnetv2体系结构将多个相同的主干网分组,这些主干网通过复合连接进行连接,可以在不增加额外成本的情况下获得良好的效果。

Swin-Trainsformer作为计算机视觉领域的强有力的backbone之一,扮演着越来越重要的角色。当DeepBlueAI团队用swin-Transformer系列替换主干时,线上结果得到了极大的改善。

后处理

1)soft nms + WBF,根据预测的score分段集成的,大于等于0.1用WBF,小于0.1用soft_nms。目的是既可以提高高分框的定位精度,增加召回从而提升mAP;

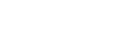

2)模型集成,使用不同backbone以及pipeline训练。

消融实验结果

本文针对Visdrone挑战赛设计了一套解决方案包括数据处理,检测器和轨迹后处理,DeepBlueAI团队表示:“很荣幸在Visdrone 2021取得第一名的成绩”。同时团队也在多目标跟踪赛道取得了不错的成绩,接下来会介绍MOT相关技术内容。

VisDrone MOT 方案解读

VisDrone Mot 赛道获奖证书

Pipeline

对于同一挑战赛的MOT赛道,DeepBlueAI团队也总结了相关难点并设计出一套相关的pipeline。

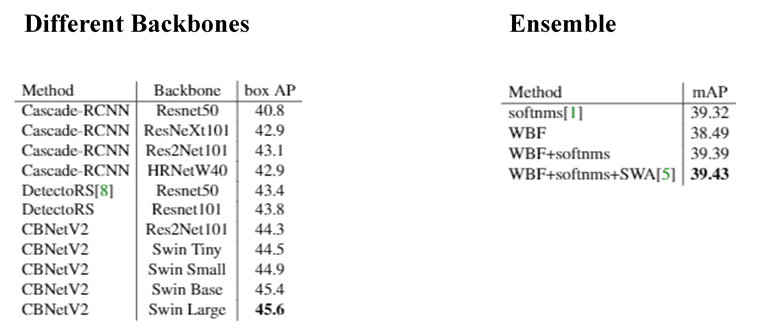

本次采用的多目标跟踪系统是DeepBlueAI团队长时间以来总结的一套比较好的pipeline,在竞赛中多次取得不错的成绩,基于Detection和Embedding分离的方法,团队采用了以GeneralizedFocal Loss(GFL)为损失的anchor-free检测器,并以MultipleGranularity Network (MGN)作为Embedding模型。在关联过程中,DeepBlueAI团队借鉴了DeepSORT和FairMOT的思想,构建了一个简单的在线多目标跟踪器。

Detector

对于检测器DeepBlueAI团队使用了GFLDetector、Generalized Focal Loss(GFL),更具体的来说,GFL可以分成QualityFocal Loss(QFL)以及Distribution Focal Loss(DFL)。

QFL专注于asparse set of hard examples,同时在相应的类别上产生它们的连续0~1之间的localizationquality estimation;DFL使网络能够在任意和灵活的分布下,学习bounding boxes在连续位置上的概率值。

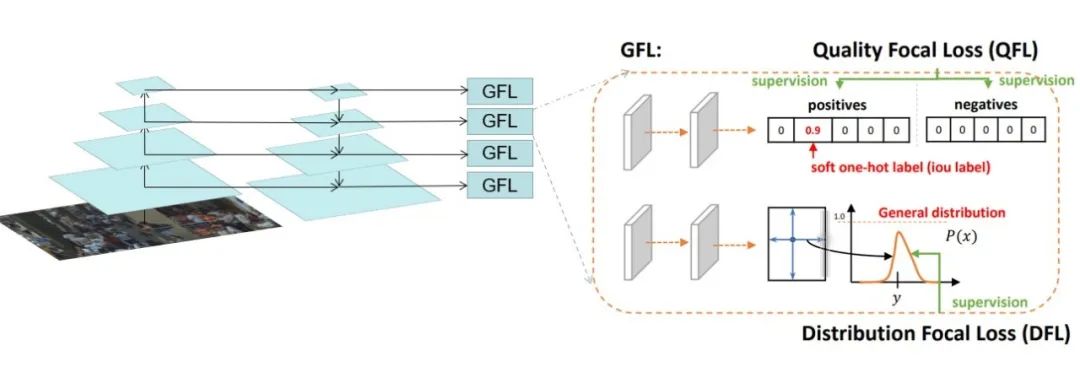

Embedding

MGN把全局和局部的特征结合在一起,能够有丰富的信息和细节去表征输入图片的完整情况。在观察中发现,确实是随着分割粒度的增加,模型能够学到更详细的细节信息,全局特征跟多粒度局部特征结合在一起,思路比较简单,全局特征负责整体的宏观上大家共有的特征的提取,然后把图像切分成不同块,每一块不同粒度,它去负责不同层次或者不同级别特征的提取。

Data Association

DeepBlueAI团队借鉴了DeepSORT和FairMOT的想法,以检测框的表观距离为主,以检测框的空间距离为辅。首先,根据第一帧中的检测框初始化多个轨迹。在随后的帧中,团队根据embedding features之间的距离(最大距离限制为0.7),来将检测框和已有的轨迹做关联。与FairMOT一致,每一帧都会通过指数加权平均更新跟踪器的特征,以应对特征变化的问题。对于未匹配的激活轨迹和检测框通过他们的IOU距离关联起来(阈值为0.8)。最后,对于失活但未完全跟丢的轨迹和检测框也是由它们的IoU距离关联的(阈值为0.8)。

Post Process

由于只有较高的置信度的检测框进行跟踪,因此存在大量假阴性的检测框,导致MOTA性能低下。为了减少置信阈值的影响,DeepBlueAI团队尝试了两种简单的插值方法。

1) 对总丢失帧不超过20的轨迹进行线性插值。我们称之为简单插值(simple interpolation, SI)。

2)对每一个轨迹只在丢失不超过4帧的帧之间插入。另外,DeepBlueAI团队称之为片段插值(fragment interpolation,FI)。

Result

Conclusion

DeepBlueAI团队设计了一个简单、在线的多目标跟踪系统,包括检测器、特征提取、数据关联和轨迹后处理,最终在VisDrone 2021 MOT赛道斩获冠军。

-

8项冠亚季军收官ECCV2020,深兰获三大视觉顶会挑战赛大满贯

计算机视觉 -

与腾讯、哈工大同台竞技,深兰获自然语言处理领域国际顶会NAACL2021冠军

计算机视觉 -

捷报 | 深兰科技“双队”出征CVPR2021 斩获五冠共获14项大奖

计算机视觉 -

2022CVPR传捷报丨深兰科技再度折桂,连续4届获得CVPR挑战赛冠军

计算机视觉 -

深兰科技夺冠CCKS2022“带条件的分层级多答案问答”评测任务竞赛

自然语言处理 -

PK 656 个对手!深兰科技在全球顶级AI赛事kaggle竞赛中再次夺冠

计算机视觉 -

一冠三亚二季!深兰科技在EMNLP2022国际顶级赛事再创佳绩

数据挖掘 -

6个奖项!深兰科技在CVPR 2023挑战赛中再获佳绩

计算机视觉 -

6冠3亚2季!深兰科技在RANLP2023国际赛事上斩获11项大奖

计算机视觉